本文《Improving Real-world Password Guessing Attacks via Bi-directional Transformers》提出了一种基于双向变换器(Bi-directional Transformers)的创新密码猜测框架PassBERT,重点研究了预训练/微调范式在密码攻击中的应用。

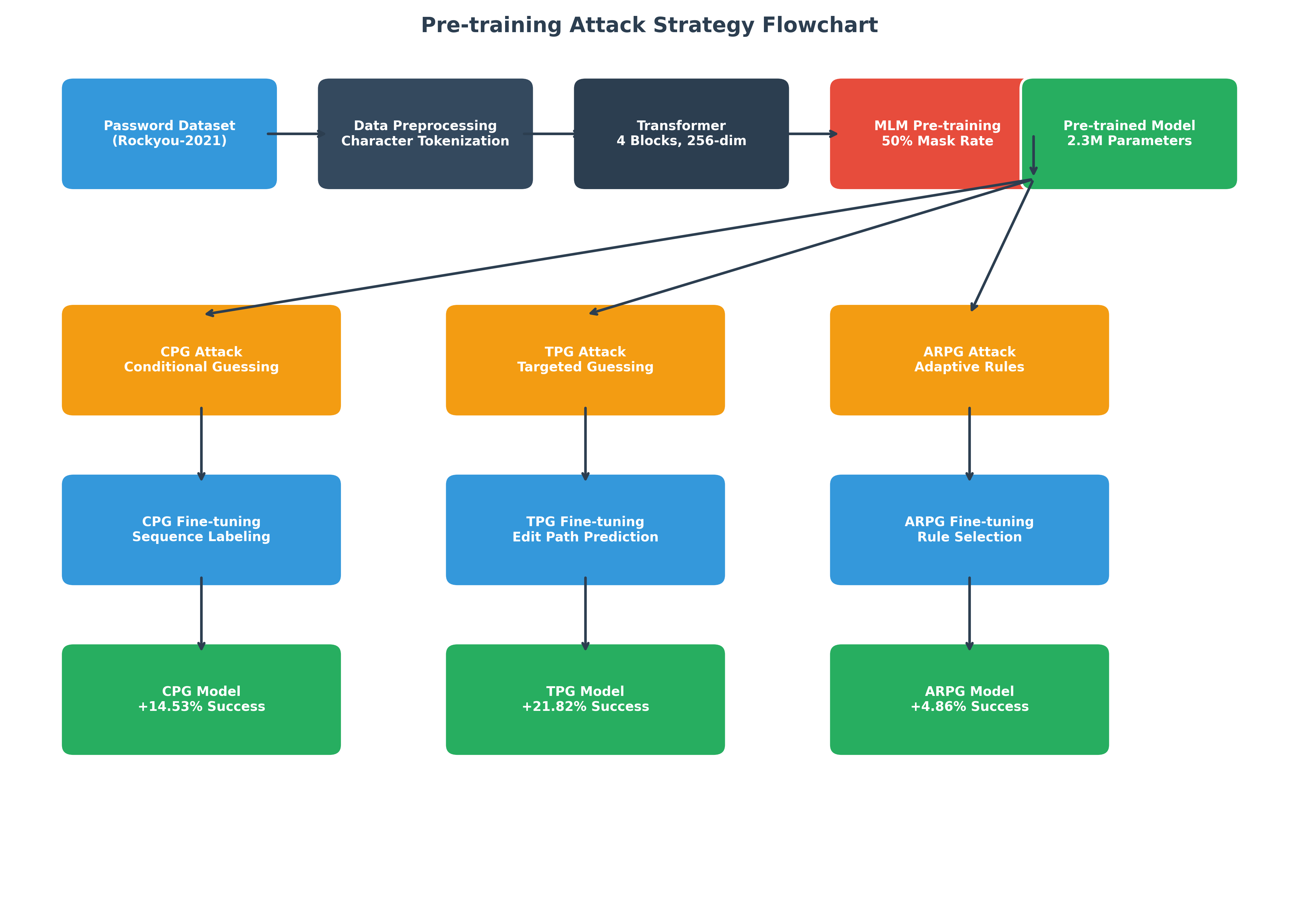

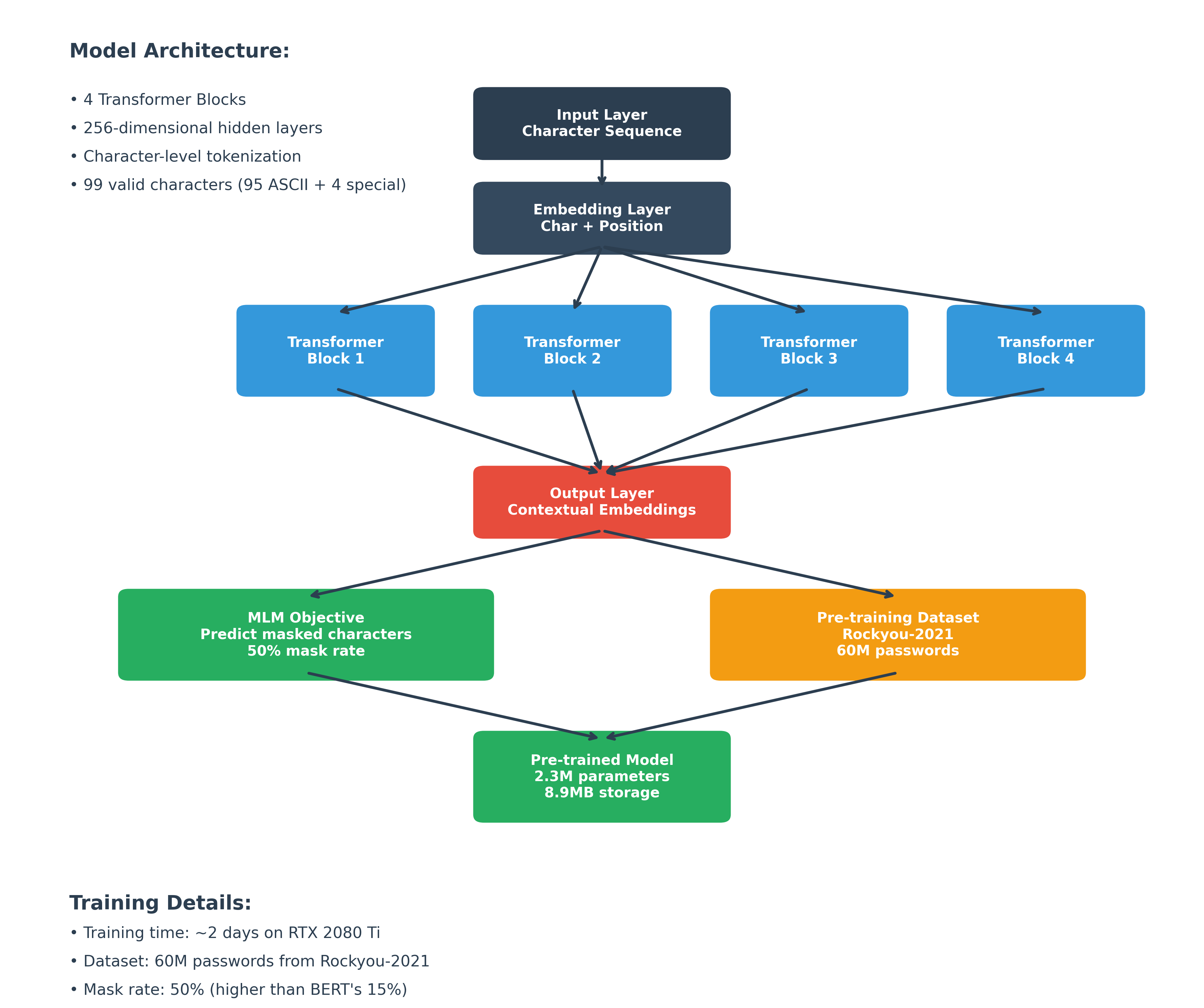

核心贡献:该研究首次将BERT的预训练/微调范式系统性地应用于密码攻击领域,通过构建通用的密码预训练模型,显著提升了三种实际攻击场景的成功率。

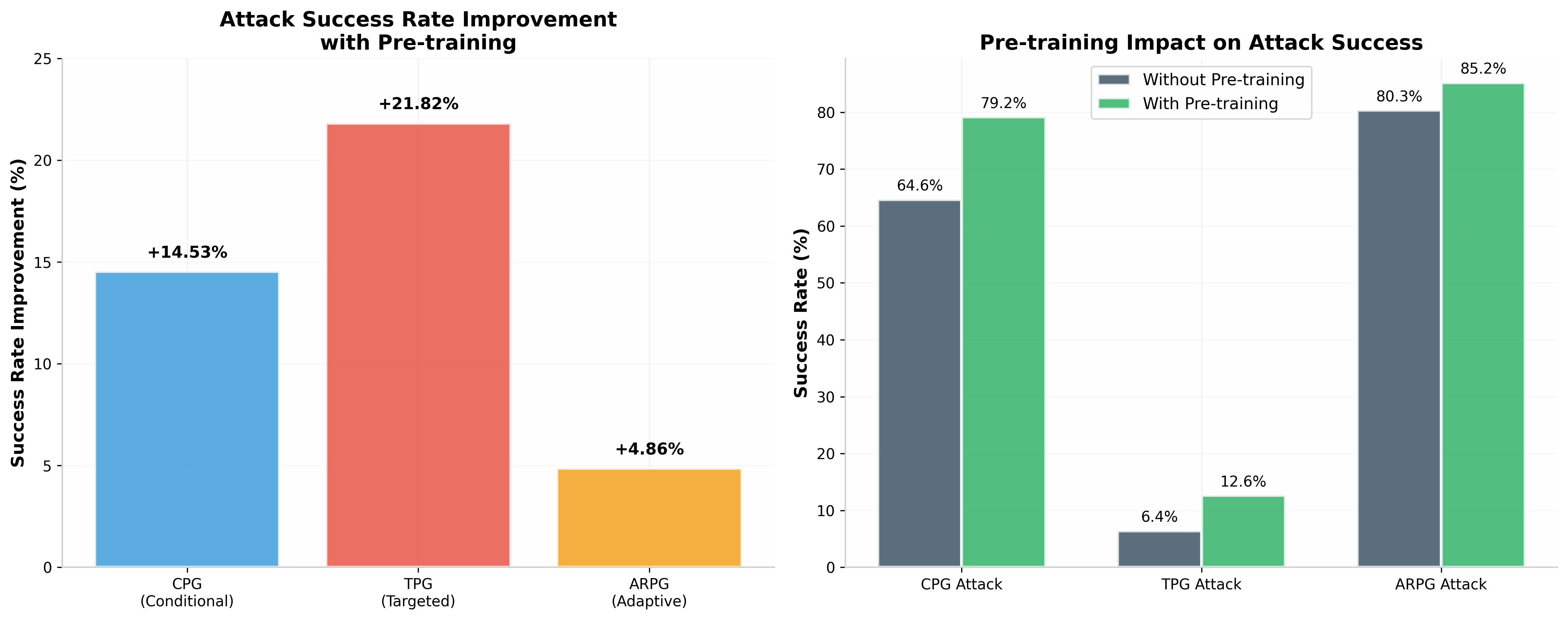

14.53%

CPG攻击成功率提升

21.82%

TPG攻击成功率提升

4.86%

ARPG攻击成功率提升

2.3M

预训练模型参数数量

三种攻击场景

- 条件密码猜测(CPG):基于部分已知密码信息恢复完整密码

- 目标密码猜测(TPG):利用个人信息针对特定用户的密码攻击

- 自适应规则密码猜测(ARPG):智能选择密码变形规则生成候选密码